Has “vendido” tu iris a la empresa Worldcoin, y ahora ¿qué?

¿Sabes cuáles son las consecuencias para ti? ¿a qué riesgos te expones? Una situación como ésta, que podríamos situar en una película futurista de los años 90 es una realidad y explica a la perfección la relación entre Compliance e Inteligencia Artificial. Entre la prevención y la represión.

Porque en este caso, y con posterioridad, ha tenido que actuar (en España) la Agencia Española de Protección de Datos con la suspensión durante 3 meses de la recogida del iris (actuación avalada por la Audiencia Nacional). Pero el escenario ideal sería que no se hubiera producido esa recopilación de información biométrica, que se hubiera actuado desde la prevención, es decir, gestionando los riesgos.

El enfoque basado en riesgos es precisamente el utilizado por el Reglamento Europeo de Inteligencia Artificial. Para aquéllos que no han trabajado en el ámbito del Compliance será una novedad, pero no se trata de un enfoque tan nuevo. Más allá de las posiciones abiertamente favorables a la aplicación de las técnicas de Compliance en el sector público, tenemos un claro antecedente en la Recomendación del Consejo de la OCDE sobre Integridad Pública.

La OCDE apuesta por un enfoque estratégico de la integridad pública basado en evidencia y destinado a atenuar los riesgos para la integridad pública. Se centra en un enfoque basado en riesgos al establecer prioridades y objetivos estratégicos para el sistema de integridad pública; elaborar puntos de referencia e indicadores; y recopilar datos pertinentes sobre la implementación, el rendimiento y la eficacia del sistema. Asimismo, aborda el desafío que supone equilibrar en las estrategias de integridad, los enfoques basados en normas y aquellos basados en valores.

¿Cómo puede el Compliance ayudar a un uso ético y responsable de la IA en la gestión pública?

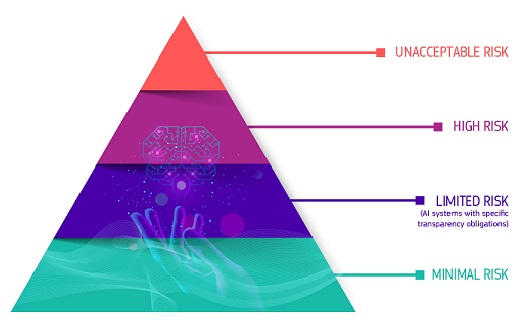

Como decía, el RIA presenta un enfoque basado en el riesgo. Establece una secuencia de niveles de riesgo y a cada uno de los niveles identificados, les asigna unas posibilidades. Evidentemente, a mayor riesgo, mayor obligaciones, llegando incluso a la prohibición en el caso de riesgos extremos para los derechos humanos por ejemplo.

Podemos distinguir así:

-

Sistemas de IA de riesgo inaceptable:

Representan una amenaza directa a la seguridad pública, la privacidad y los derechos fundamentales. Estamos hablando desde la puntuación social por parte de los gobiernos hasta los juguetes que utilizan asistencia de voz que fomentan comportamientos peligrosos. Su uso está prohibido, salvo en situaciones excepcionales como la utilización de sistemas de identificación biométrica remota por autoridades policiales en espacios públicos, con sujeción a salvaguardias.

-

Sistemas de IA de alto riesgo:

En este caso nos estamos refiriendo a usos que pueden tener impacto relevante en los derechos fundamentales de los individuos. Algunos ejemplos son las infraestructuras críticas, la educación y la formación profesional, el empleo, los servicios públicos y privados esenciales (por ejemplo, la sanidad o la banca), determinados sistemas de las fuerzas de seguridad, la migración y la gestión aduanera, la justicia y los procesos democráticos (como influir en las elecciones). Tampoco está permitido el reconocimiento de emociones en el lugar de trabajo y en las escuelas, sistemas de puntuación ciudadana, la actuación policial predictiva (cuando se base únicamente en el perfil de una persona o en la evaluación de sus características) y la IA que manipule el comportamiento humano o explote las vulnerabilidades de las personas

- Por ese elevado riesgo, su uso está sujeto a ciertas obligaciones, como implantar sistemas adecuados de evaluación y mitigación de riesgos, registros de actividades, evaluaciones de impacto sobre los derechos fundamentales, medidas apropiadas de supervisión humana, etc.

-

Sistemas de IA de riesgo limitado:

Se trata de los sistemas de propósito general, de riesgo limitado, asociado, por ejemplo, a situaciones de uso de sistemas de IA como chatbots debemos ser conscientes de que estamos interactuando con una máquina para que puedan tomar una decisión informada de continuar o dar un paso atrás. Los proveedores también tendrán que asegurarse de que el contenido generado por IA sea identificable. Además, el texto generado por IA publicado con el propósito de informar al público sobre asuntos de interés público debe etiquetarse como generado artificialmente. Esto también se aplica al contenido de audio y video que constituyen deep fakes. Deben cumplir con ciertas obligaciones específicas de transparencia, como informar a los usuarios de que están interactuando con un sistema de IA o informar de que un contenido ha sido generado mediante IA.

-

Sistemas de IA de riesgo mínimo:

No están regulados específicamente, pero se trata de aquellos supuestos en los que las personas pueden decidir de forma libre sobre su uso (por ejemplo, videojuegos con IA o filtros de spam).

Es decir, lo primero que se exige en el recurso a la IA es una evaluación de riesgos para determinar la categorización del uso del sistema de IA, saber cuáles pueden ser los daños que se produzcan en los derechos y libertades de las personas, en el mercado, etc. Y en función de ello diseñar un sistema de gestión de esos riesgos, preservando las garantías jurídicas y el buen funcionamiento de las instituciones.

Se trata de cambiar el foco, a la prevención, tal y como dispone el Compliance, de realizar una proyección de futuro y gestionar los posibles escenarios de daños para evitarlos, para que no vayamos dejando nuestro iris al primero que nos lo pide….